Mais uma crise, crise na reprodutibilidade (e/ou replicabilidade)

O conhecimento científico cresce a partir das descobertas dos pesquisadores a favor ou contra determinada hipótese. Contudo, há uma crise no meio acadêmico referente à confiabilidade dos resultados publicados, que raramente são reproduzíveis ou replicáveis.

- Qual a diferença entre Reprodutibilidade e Replicabilidade?

Imagino que você, leitor deste blog, já deve conhecer o método científico. Mas vamos recapitular as etapas dele: Observação; Elaboração do problema; Hipóteses; Experimentação; Análise dos resultados; Conclusão. Além dessas etapas explícitas, no contexto da pesquisa médica (e de outras áreas), todo o procedimento precisa ser documentado, começando pela obtenção dos dados, passando pelos métodos empregados e por fim o registro da análise utilizada para que este trabalho possa ser replicado futuramente. E é neste aspecto da documentação que aparece o grande problema da baixa reprodutibilidade nas pesquisas atuais.

Mas o que é reprodutibilidade? É a habilidade de (re)calcular os resultados de determinado estudo. Outro conceito relacionado é o de replicabilidade que é a chance de chegar aos mesmos achados de estudos já publicados. Por isso é melhor manter o conceito de replicável no singular. Replicável é chegar nos mesmos achados repetindo os experimentos e não repetindo as análises estatísticas.

Clareando: replicabilidade que é a chance de chegar ao mesmo achado de determinado estudo quando sua metodologia é repetida. E replicabilidade é a de obter resultados similares se o estudo for repetido com outra amostragem [1].

Como muitos trabalhos não disponibilizam os dados/código que foram utilizados no artigo, torna-se complicado a re-análise por parte de outros pesquisadores [2]. De modo a mudar esse cenário, um movimento para aumentar o volume de trabalhos com dados disponíveis tem ganhado força, sendo bastante influente nos trabalhos baseados em técnicas de alto rendimento(ômicas), porém ainda incipiente nas outras áreas [1,3].

- Qual a importância de pesquisadores disponibilizarem os dados de seus estudos?

Vacina causa autismo! Né? ...piadas a parte. Isto foi um achado de um trabalha publicado (e depois retratado), que não era replicável, uma vez que as conclusões eram tão esdrúxulas que ninguém conseguiu replicar, e não era reprodutível por não se ter acesso aos dados que geraram os resultados do fatídico artigo de Wakefield. [4]

Então, sobre a reprodutibilidade, temos uma falta de transparências nas análises. Com relação a replicação, o principal empecilho é o desenho metodológico não adequado para o objetivo proposto, podendo resultar em vieses, omissão de variáveis confundidoras etc.

A disponibilização dos dados do estudo ajudaria a encontrar quais resultados não são confiáveis, uma vez que a literatura médica (e provavelmente de outras áreas) está inflacionada deles. Richard Horton (Editor Chefe da Lancet) corrobora com essa afirmação ao atestar que: “ The case against science is straightforward: much of the scientific literature, perhaps half, may simply be untrue” [5]. Mas apenas ter a disposição os dados dos trabalhos não resolve o problema dos estudos não replicáveis, para isso precisamos endereçar a questão da crise na reprodutibilidade/replicabilidade.

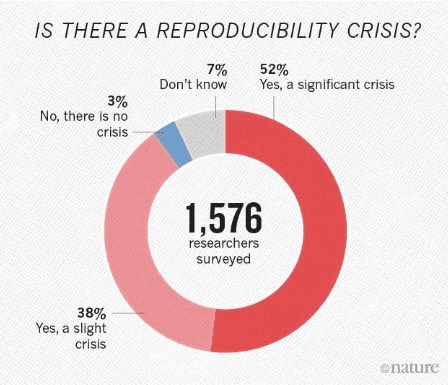

Figura 1: Pesquisa aplicada pela revista Nature a 1500 cientistas.

Fonte: 1,500 scientists lift the lid on reproducibility [6]

- Quais podem ser os motivos para essa crise?

- A quantidade exponencial de trabalhos submetidos/publicados

- “Publicar ou perecer”

- Fatiar a publicação – Tática do salame.[7]

O primeiro item pode gerar problemas em como garantir um controle de qualidade para o número crescente de publicações. O segundo, de tentar publicar custe o que custar, incluindo falsear ou manipular os dados até sair um resultado, e assim, raramente divulgando os dados. O terceiro, de não divulgar os dados para utilizar em outro artigo e assim inflar a produtividade acadêmica.

Como pode ser combatido esse problema?

- Metaciência

- Pré-registro

- Enfatizar a importância de estudos de replicação

- Aumentar os padrões de apresentação de metodologia nos artigos

- Melhorar o conhecimento estatístico dos cientistas

1. Metaciência é exatamente o que o nome diz, a ciência da ciência, em que é utilizado metodologia científica para estudar a ciência. É uma área que ajuda a entender o quão ruim está a nossa situação.

2. Pré-registro pode reduzir o viés de publicação, uma vez que o autor é obrigado a informar os métodos e plano de análise antes da coleta de dados. Impedindo de mudar o objetivo apenas para encontrar um resultado positivo.

3. Replicar, replicar, replicar. Há quase nenhum glamour em estudos de replicação, porém, são eles que podem solidificar o conhecimento produzido. Contudo, muitas revistas não aceitam para publicação estudos nessa categoria.

4. As metodologias de artigos publicados nem sempre enquadram todas as etapas realizadas com o detalhe necessário, além disso, com o aumento da complexidade das metodologias e técnicas utilizadas para a produção de dados é muito difícil revisores não especialistas no assunto conseguirem perceber se falta ou não uma informação crucial para a análise crítica do estudo. Nesse sentido, um corpo editorial focado em metodologias seria uma boa alternativa.

5. Estatística... “garbage in, garbage out” ... é uma ciência que deveria receber a atenção necessária, uma vez que as conclusões dos artigos são derivadas dos resultados obtidos pelos métodos estatísticos. Sendo já um problema antigo na área médica, uma análise feita em 1966 de artigos de 10 revistas bastante consagradas mostrou que no máximo 25% (N=295) dos artigos tinham conclusões válidas perante seus achados estatísticos.[8]

- Conclusão

Uma combinação de boas práticas em pesquisa, com uma maior transparência no processo editorial/publicação dos artigos são essenciais para podermos escapar dessa crise. Além disso, devemos aumentar nossa habilidade leitura crítica dos artigos para duvidar dos resultados expostos, quando for necessário.

REFERÊNCIAS

- Leek, Jeffrey T., and Roger D. Peng. "Opinion: Reproducible research can still be wrong: Adopting a prevention approach." Proceedings of the National Academy of Sciences 112.6 (2015): 1645-1646.

- Colavizza, Giovanni, et al. "The citation advantage of linking publications to research data." PloS one 15.4 (2020): e0230416.

- https://theplosblog.plos.org/2019/12/building-the-foundation-for-future-research-through-open-data-code-and-protocols/

- Wakefield, Andrew J., et al. "RETRACTED: Ileal-lymphoid-nodular hyperplasia, non-specific colitis, and pervasive developmental disorder in children." (1998): 637-641.

- Horton, Richard. "Offline: What is medicine’s 5 sigma." Lancet 385.9976 (2015): 1380.

- Baker, Monya. "1,500 scientists lift the lid on reproducibility." (2016).

- Editorial. "The cost of salami slicing." Nature Materials 4.1 (2005): 1.

- Schor, Stanley, and Irving Karten. "Statistical evaluation of medical journal manuscripts." Jama 195.13 (1966): 1123-1128.

0 Comentários